En los últimos meses hemos visto un avance en el mundo de la robótica y los humanoides impulsados con IA como nunca antes había ocurrido en la historia. Sin embargo, no había anuncio que no llegara a acompañado de cierta sensación de incomodidad ante lo logrado, ese valle inquietante que nos hace ver las apariencias de esas réplicas de metal de nosotros con algo de rechazo. Lo último en robótica va precisamente enfocado a rebajar esa sensación.

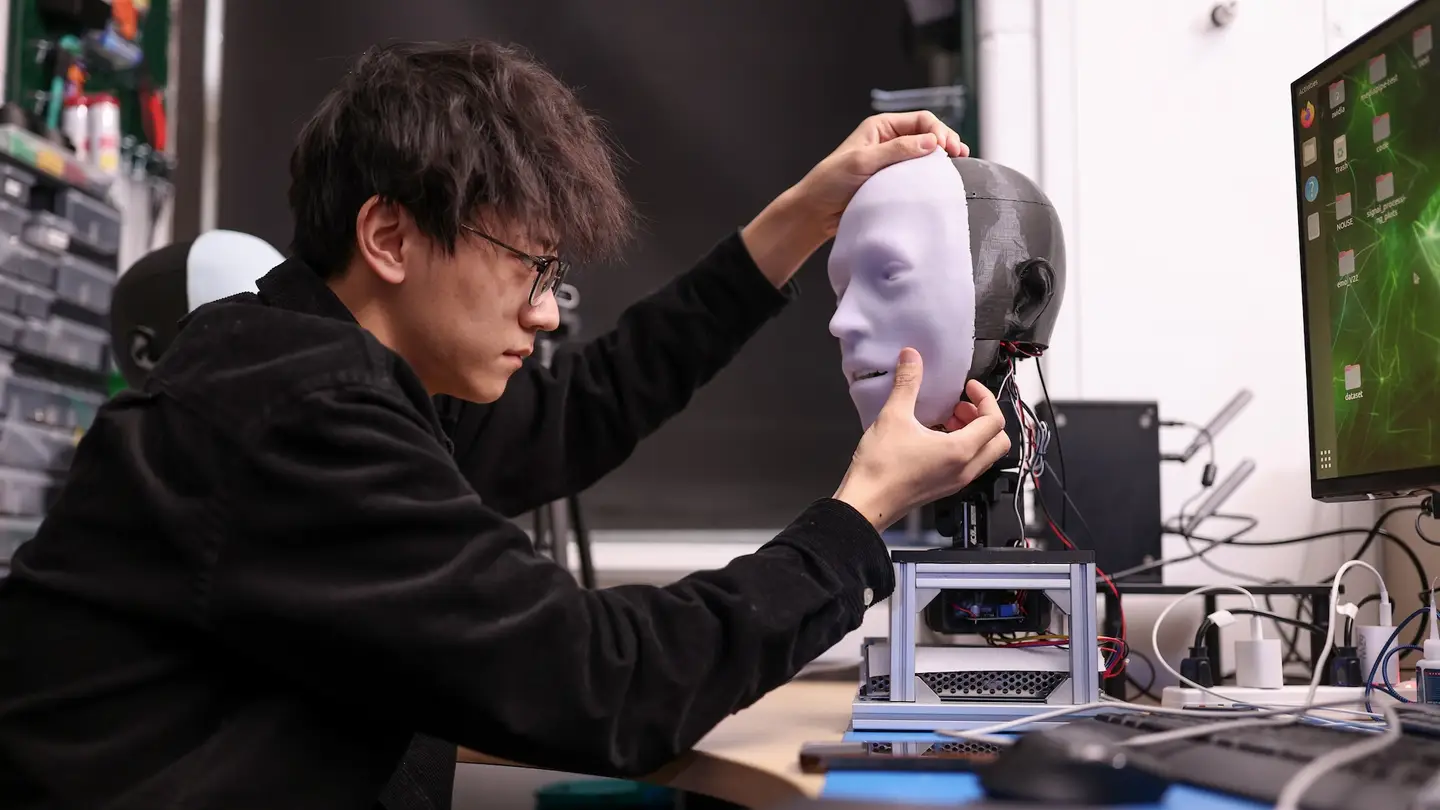

Detrás de este increíble avance se encuentra el Creative Machines Lab de Columbia Engineering, quienes llevan más de cinco años trabajando en este desafío. En el nuevo estudio publicado en Science Robotics, el grupo ha presentado a Emo, un robot que anticipa las expresiones faciales y las ejecuta simultáneamente con un humano. Incluso ha aprendido a predecir una próxima sonrisa unos 840 milisegundos antes de que la persona sonría y a coexpresar la sonrisa simultáneamente con dicha persona.

El equipo, dirigido por Hod Lipson, un investigador experto en los campos de la inteligencia artificial (IA) y la robótica, cuenta que se ha enfrentado a dos desafíos: cómo diseñar mecánicamente una cara robótica expresivamente versátil que involucre hardware y mecanismos de actuación complejos, y saber qué expresión generar “para que parezcan naturales, oportunos y genuinos”.

Para ello, los investigadores se propusieron entrenar un robot que fuera capaz de anticipar futuras expresiones faciales en humanos y ejecutarlas simultáneamente con una persona. De hecho y como recuerdan en el estudio, el momento de estas expresiones fue crítico: la mímica facial retrasada parece falsa, pero la coexpresión facial se siente más genuina ya que requiere inferir correctamente el estado emocional del ser humano para una ejecución oportuna.

Para construir el nuevo robot, el equipo diseñó primero una cabeza humana robótica realista que incluye 26 actuadores separados para permitir pequeños rasgos de expresión facial. Cada una de las pupilas de Emo también contenía cámaras de alta resolución para seguir los ojos de su interlocutor humano, otra señal visual no verbal importante para las personas. Finalmente, el equipo de Lipson colocó una “piel” de silicona sobre las partes mecánicas de Emo para hacerlo todo un poco menos “robótico”.

Luego, los investigadores construyeron dos modelos de IA separados para trabajar en conjunto: uno para predecir las expresiones humanas a través de las minúsculas expresiones de la cara de un objetivo y otro para emitir rápidamente respuestas motoras para la cara de un robot. Utilizando videos de muestra de expresiones faciales humanas, la IA de Emo aprendió las complejidades emocionales frame a frame.

De hecho, en tan sólo unas horas, Emo fue capaz de observar, interpretar y responder a los pequeños cambios faciales que las personas tienden a hacer cuando empiezan a sonreír. Es más, como han anunciado, ahora puede hacerlo en unos 840 milisegundos. Según ha explicado Yuhang Hu, estudiante de doctorado en ingeniería de Columbia y autor principal del estudio:

Creo que predecir con precisión las expresiones faciales humanas es una revolución en [las interacciones entre humanos y robots. Tradicionalmente, los robots no han sido diseñados para considerar las expresiones humanas durante las interacciones. Ahora, el robot puede integrar expresiones faciales humanas como retroalimentación. Cuando un robot hace coexpresiones con personas en tiempo real, no sólo mejora la calidad de la interacción sino que también ayuda a generar confianza entre humanos y robots. En el futuro, cuando interactúes con un robot, éste observará e interpretará tus expresiones faciales, como una persona real.

Eso sí, como recuerdan en el estudio, Emo carece de habilidades de interpretación verbal, por lo que por ahora solo puede interactuar analizando las expresiones faciales humanas. Los investigadores esperan combinar pronto las habilidades físicas con un sistema modelo de lenguaje de gran tamaño como ChatGPT. Si pueden lograrlo, Emo estará aún más cerca de las interacciones humanas naturales (o lo más cerca que un androide lo ha estado hasta la fecha).

Hablamos, por supuesto, de mucho más que sonrisas y expresiones de satisfacción en la identificación, y que los futuros robots puedan saber qué hacer con nuestros muecas y ceños fruncidos.

Deja un comentario