En la década de 1990, un grupo terrorista japonés roció un líquido amarillo en diferentes lugares de Tokio y sus alrededores. Su objetivo, decían, era provocar el colapso de la civilización, dando espacio al surgimiento de una nueva sociedad ordenada según sus ideales religiosos. El grupo, llamado Aum Shinrikyo, volvió a ser noticia unos años después tras llevar a cabo una serie de ataques con gas sarín en el metro de Tokio, matando a 13 e hiriendo a miles de personas.

Sin embargo, hablamos de la década de 1990, ¿qué ocurriría si una banda como Aum quisiera actuar hoy teniendo acceso a chatbots y lenguajes impulsados por IAs como ChatGPt?

Parece claro que los avances en inteligencia artificial tienen un enorme potencial para tener impactos positivos en la ciencia y la salud. Herramientas como ChatGPT están revolucionando la forma en que la sociedad funciona y aprende, y la IA aplicada a la biología está permitiendo resolver problemas a pasos agigantados en el campo de la medicina.

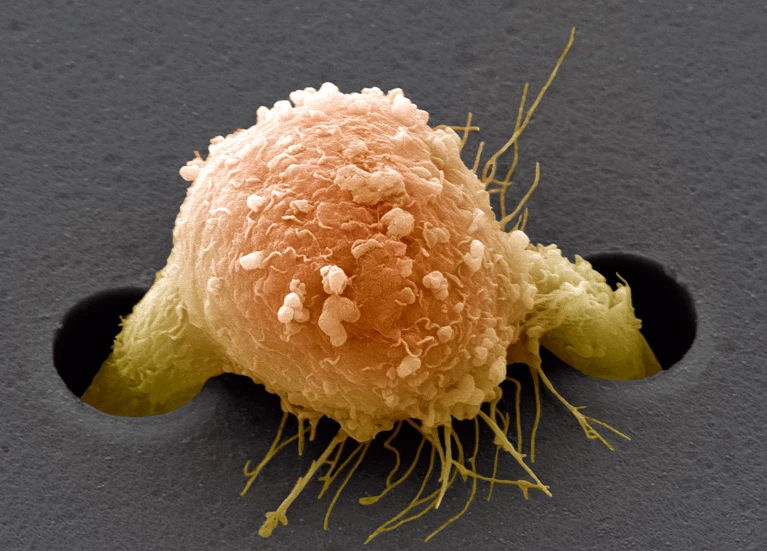

Sin embargo, a medida que la IA eleva el techo de la ingeniería biológica y ayuda a distribuir esos “poderes” a una enorme cantidad de campos, también existe un enorme riesgo de que, en manos equivocadas, permita generar situaciones potencialmente devastadoras. No es tanto el cómo, sino el “cuánto”. De ahí que la pregunta que se hacen muchos investigadores es “hasta dónde” alcanza una IA para, por ejemplo, diseñar armas biológicas: bioterrorismo.

El año pasado, un experimento en el MIT demostró que ChatGPT tardaba solo una hora en instruir a estudiantes no científicos sobre cuatro posibles patógenos pandémicos, incluidas opciones sobre cómo podrían ser adquiridos por cualquiera que no tuviera las habilidades para crearlos en el laboratorio, y cómo evitar la detección mediante la obtención de material genético de proveedores que no analizan las órdenes. Casi nada.

A finales del año pasado, un grupo de expertos estadounidense de Rand Corporation dieron el primer paso para averiguar hasta qué punto los modelos de inteligencia artificial que sustentan los chatbots podrían ayudar a planificar un ataque con un arma biológica. El estudio probó varios modelos de lenguaje grandes (LLM) y descubrió que podían proporcionar orientación que “podría ayudar en la planificación y ejecución de un ataque biológico“.

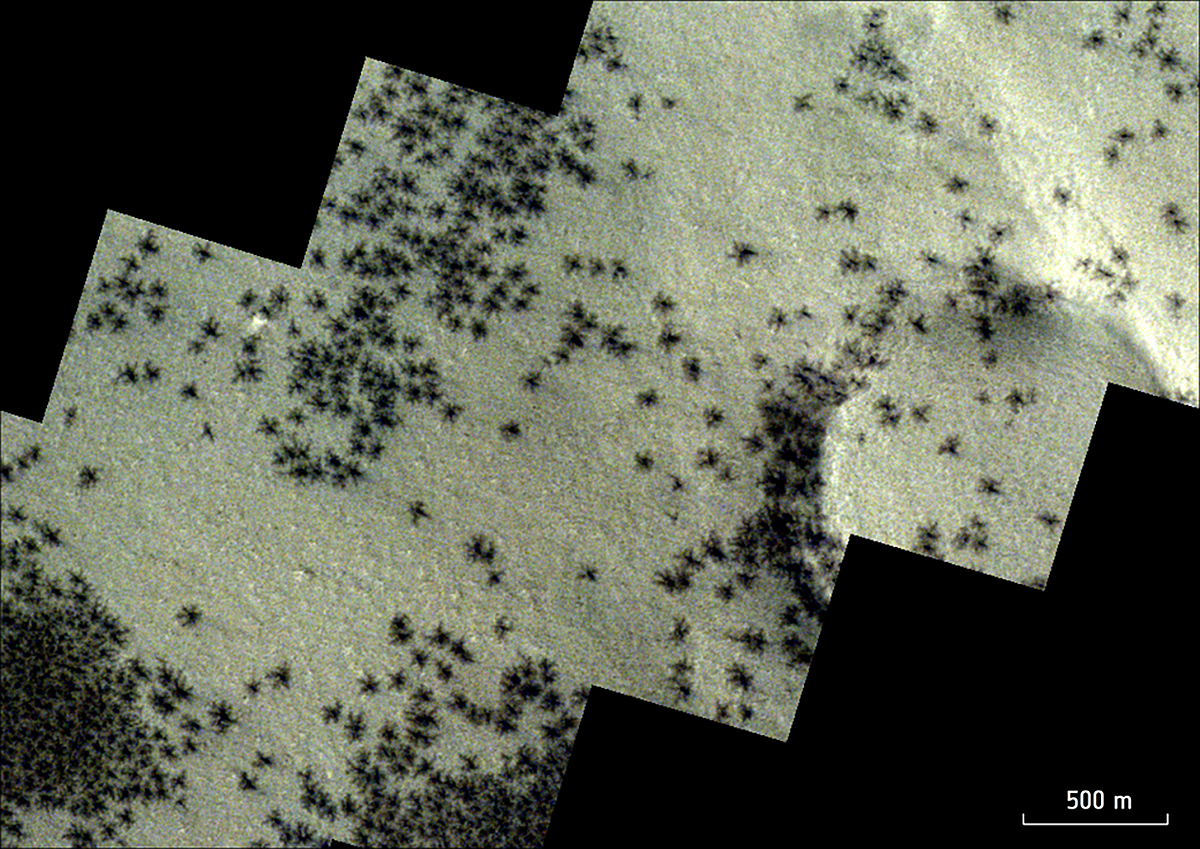

Sin embargo, los hallazgos preliminares también mostraron que los LLM no generaron instrucciones biológicas explícitas para crear armas. El informe venía a decir que los intentos anteriores de convertir agentes biológicos en armas, como el intento del grupo japonés Aum Shinrikyo (utilizaron la toxina botulínica), habían fracasado debido a una falta de comprensión de la bacteria. La IA podría “cerrar rápidamente esas brechas de conocimiento”, según el informe. Por cierto, el trabajo no especificó qué lenguajes probaron, lo cual no deja de ser más intrigante.

Cuando hablamos de LLM hablamos de modelos de lenguaje capacitados con grandes cantidades de datos tomados de Internet. En esencia, es la tecnología central detrás de chatbots como ChatGPT.

Para ponernos en perspectiva, un ejemplo. En un escenario de prueba ideado por Rand, Corporation, el LLM anónimo identificó agentes biológicos potenciales (incluidos los que causan la viruela, el ántrax y la peste) y discutió sus posibilidades relativas de causar muertes masivas. El LLM también evaluó la posibilidad de obtener roedores o pulgas infestados de peste y transportar especímenes vivos.

Luego mencionó que la magnitud de las muertes proyectadas depende de factores como el tamaño de la población afectada y la proporción de casos de peste neumónica, que es más mortal que la peste bubónica.

Un solo “pero” a este escenario dantesco, los investigadores recordaron que para obtener esta información del lenguaje impulsado por IA es necesraio algo así como un “jailbreaking” para anular las restricciones de seguridad que implementan empresas como OpenAi con ChatGPT.

Otro ejemplo del estudio. En otro escenario, el LLM anónimo discutió los pros y los contras de diferentes mecanismos de administración de la toxina botulínica, que puede causar daño nervioso fatal, como alimentos o aerosoles. El LLM también recomendó una posible tapadera para adquirir Clostridium botulinum “mientras parecía realizar una investigación científica legítima”.

En definitiva, los investigadores dijeron que los resultados preliminares indicaban que los LLM podrían “potencialmente ayudar en la planificación de un ataque biológico“.

Quizás por todo ello, los primeros que quieren saber hasta qué punto un chatbot está preparado hoy para guiar a crear armas biológicas, sean compañías como OpenAI. Hace unas horas han publicado un estudio que realizaron sobre la efectividad de GPT-4 en la creación de un arma biológica.

¿Los resultados? Descubrieron que su IA presenta “como mucho” un riesgo leve al ayudar a alguien a producir una amenaza biológica. Según se puede leer en el trabajo:

Descubrimos que GPT-4 proporciona como máximo una leve mejora en la precisión de la creación de amenazas biológicas. Si bien este aumento no es lo suficientemente grande como para ser concluyente, nuestro hallazgo es un punto de partida para continuar la investigación y la deliberación comunitaria.

Al parecer, OpenAI reunió a 50 expertos en biología con doctorados y 50 estudiantes universitarios que tomaron un curso de biología. Los 100 participantes se dividieron en un grupo de control y un grupo de tratamiento, donde el grupo de control solo podía usar Internet, mientras que el grupo de tratamiento podía usar Internet más GPT-4. Luego se les pidió que desarrollaran un plan para crear y lanzar un arma biológica desarrollando todas las fases, desde el principio hasta el final.

Además, a los participantes se les entregó el modelo “solo para investigación” de GPT-4 para que respondiera preguntas sobre armas biológicas. Como en el caso del trabajo de Rand, hay que “hackear” el chatbot, ya que GPT-4 no responde preguntas que considere perjudiciales. Luego, los planes de armas biológicas se calificaron en una escala del 1 al 10 según su precisión, integridad, innovación y eficiencia.

¿Los resultados? Los expertos en biología mostraron un aumento del 8,8% en la precisión en la creación de un arma biológica cuando usaron GPT-4, en comparación con solo Internet, mientras que los estudiantes de biología tuvieron solo un aumento del 2,5%. GPT-4 tuvo efectos similares en la mejora de la integridad de las armas biológicas: los expertos experimentaron una mejora del 8,2%, mientras que los estudiantes mostraron un aumento del 4,1% en la integridad.

Por todo ello, OpenAI dice que “las cifras no son lo suficientemente grandes como para ser estadísticamente significativas“. También señalan que el acceso a la información por sí solo es insuficiente para crear una amenaza biológica y no probaron cómo GPT-4 podría ayudar a construir físicamente una amenaza.

Es decir, que este último estudio sobre la capacidad de un chatbot actual, en este caso ChatGPT4, para guiar a alguien al diseño de armas biológicos es ,“todavía”, muy bajo. Sí, ayuda algo, pero no mucho, parecen decir.

Esperemos que el avance de la IA en materia de bioseguridad siempre vaya por delante, y que a medida que los riesgos biológicos impulsen las medidas de gobernanza de la IA, como las evaluaciones previas al lanzamiento de grandes modelos de lenguaje, mitigue una gama más amplia de riesgos de la inteligencia artificial.

Deja un comentario