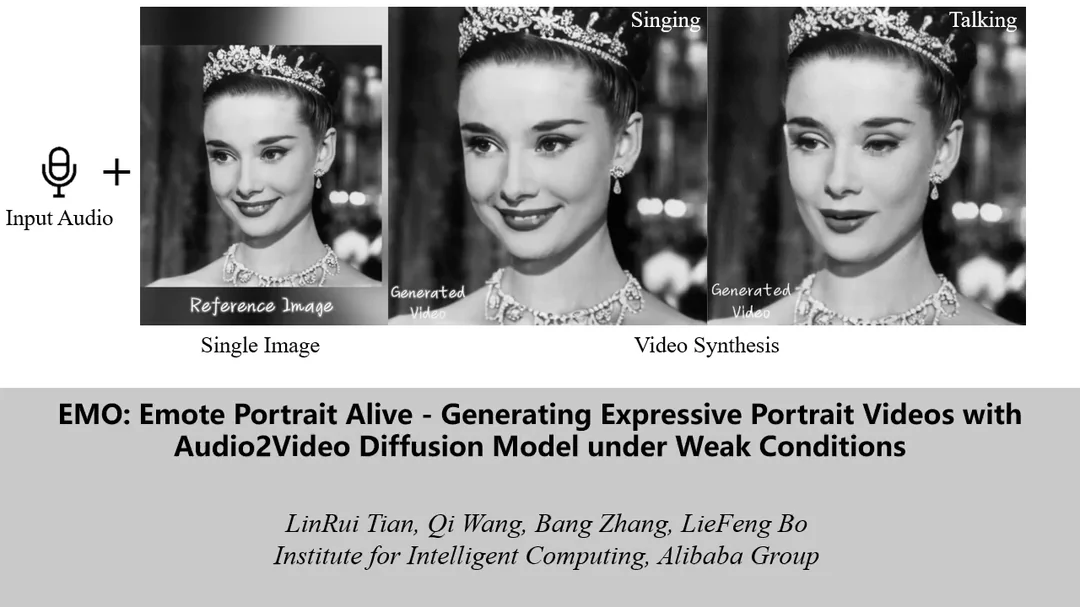

La primera imagen a la izquierda del vídeo que vamos a ver a continuación es un fotograma congelado de Audrey Hepburn interpretando a la princesa Anna en la película Vacaciones en Roma (1953). La segunda también nos muestra a la actriz en el mismo escenario. En este caso, es un pequeño clip de la película donde sale cantando. Sin embargo, hay algo raro. Hepburn está interpretando la canción Perfect, de Samantha Harvey, un single que salió en 2020. Por último, la tercera imagen nos muestra otra vez la misma escena, pero esta vez es un clip donde Hepburn, en vez de cantar, nos está dando un discurso perfecto.

¿Qué clase de brujería es esta?

Cuando OpenAI presentó ese tráiler casi perfecto de su nueva herramienta Sora, capaz de generar vídeo a través de texto, nos quedamos asombrados vislumbrando la revolución que puede suponer. Lo que se acaba de presentar es, si cabe, aún más espectacular. Me pregunto que estarán pensando en la industria cinematográfica cuando vean cosas como estas. Nunca pensé que este nivel de detalle en la sincronización del diálogo con la expresión humana le iba a llevar tan poco tiempo a la inteligencia artificial. Es ridículo lo increíblemente bien que se ven todas y cada una de las animaciones.

Lo que vamos a ver a continuación es un trabajo publicado hace unas horas en Arxiv por Linrui Tian, Qi Wang, Bang Zhang y Liefeng Bo, todos investigadores del Instituto de Inteligencia en Computación de Alibaba Group. Lo que presentan: su programa EMO (Emote Portrait Alive) diseñado para generar videos de retratos expresivos en condiciones de todo tipo. Un modelo alucinante que aprovecha la técnica de Audio2Video Diffusion, lo que permite la síntesis de animaciones realistas que reflejan las expresiones humanas y los movimientos de la cabeza con una precisión ciertamente asombrosa.

Veamos la alucinante secuencia:

Como vemos en las diferentes secuencias del trabajo recientemente publicado, EMO se destaca por su capacidad para crear videos a partir de una única imagen de referencia y entrada de audio (una foto, un fotograma, un cuadro, un manga…), puede ser un discurso o una canción, produciendo animaciones con expresiones faciales matizadas y posturas dinámicas de la cabeza.

No encuentro palabras para definir bien lo que parece que han logrado. A diferencia de los métodos tradicionales que se basan en modelos 3D o puntos de referencia faciales, el nuevo programa utiliza un enfoque de síntesis directa de audio a video. Dicho de otra forma: hablamos de la capacidad de generar transiciones con resultados tan perfectos como los reales, y de darle coherencia de identidad en todos los fotogramas.

Hoy es la princesa Anna que interpretó Audrey Hepburn en Roman Holiday, Joaquin Phoenix en Joker o la Mona Lisa, que se ha levantado con ganas de charlar, mañana podrá ser prácticamente cualquier cosa.

Deja un comentario